4.2.2. Clasificación.

Clasificación de redes neuronales según la topología de red

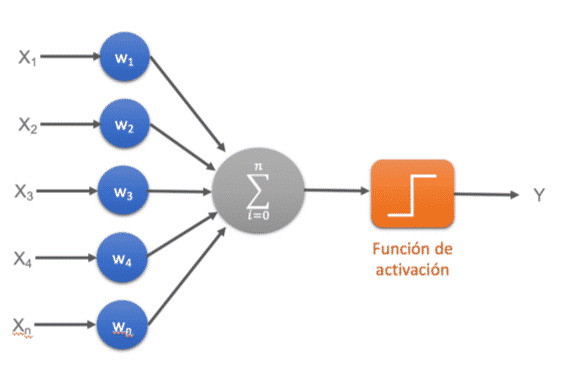

Red neuronal Monocapa – Perceptrón simple

La red neuronal monocapa se corresponde con la red neuronal más simple, está compuesta por una capa de neuronas que proyectan las entradas a una capa de neuronas de salida donde se realizan los diferentes cálculos.

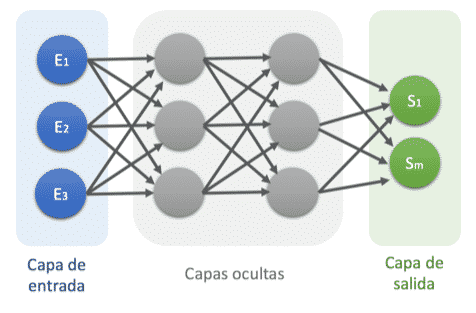

Red neuronal Multicapa – Perceptrón multicapa

La red neuronal multicapa es una generalización de la red neuronal monocapa, la diferencia reside en que mientras la red neuronal monocapa está compuesta por una capa de neuronas de entrada y una capa de neuronas de salida, esta dispone de un conjunto de capas intermedias (capas ocultas) entre la capa de entrada y la de salida.

Dependiendo del número de conexiones que presente la red esta puede estar total o parcialmente conectada.

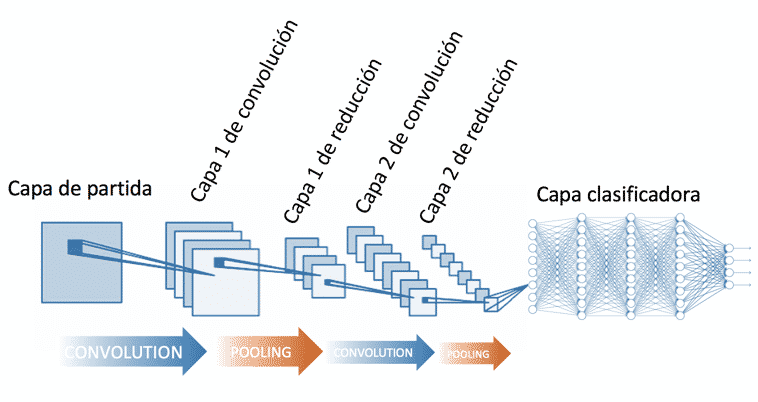

Red neuronal Convolucional (CNN)

La principal diferencia de la red neuronal convolucional con el perceptrón multicapa viene en que cada neurona no se une con todas y cada una de las capas siguientes sino que solo con un subgrupo de ellas (se especializa), con esto se consigue reducir el número de neuronas necesarias y la complejidad computacional necesaria para su ejecución.

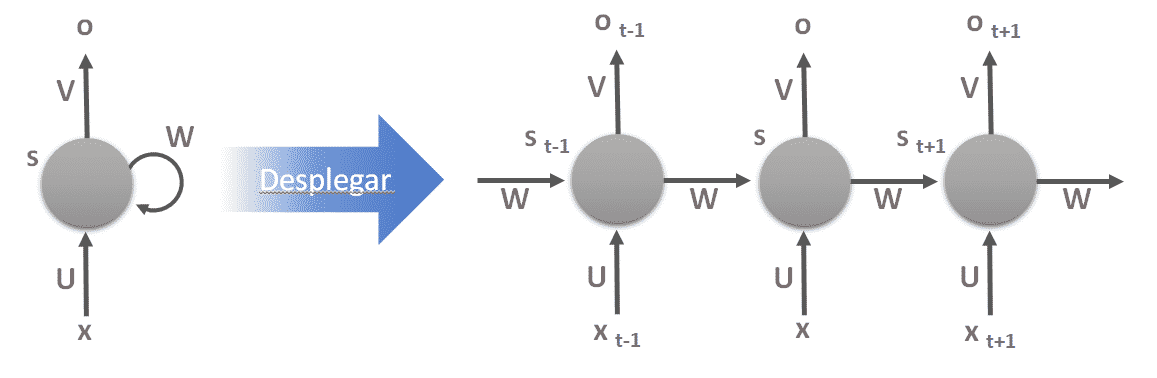

Red neuronal recurrente (RNN)

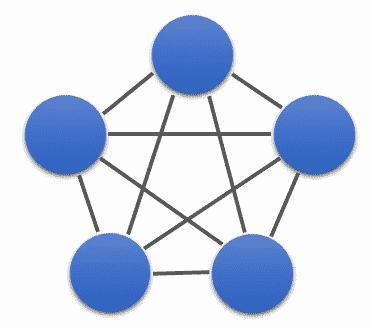

Las redes neuronales recurrentes no tienen una estructura de capas, sino que permiten conexiones arbitrarias entre las neuronas, incluso pudiendo crear ciclos, con esto se consigue crear la temporalidad, permitiendo que la red tenga memoria.

Los datos introducidos en el momento t en la entrada, son transformados y van circulando por la red incluso en los instantes de tiempo siguientes t + 1, t + 2, …

Redes de base radial (RBF)

Las redes de base radial calculan la salida de la función en función de la distancia a un punto denominado centro. La salida es una combinación lineal de las funciones de activación radiales utilizadas por las neuronas individuales.

Las redes de base radial tienen la ventaja de que no presentan mínimos locales donde la retro propagación pueda quedarse bloqueada.

Clasificación de redes según el método de aprendizaje

Aprendizaje supervisado

Aprendizaje por corrección de error.

- Perceptrón

- Delta o Mínimo error cuadrado (LMS Error: Least Mean Squared)

- Backpropagation o Programación hacia atrás (LMS multicapa)

Aprendizaje estocástico

Aprendizaje no supervisado o auto supervisado

Se caracteriza porque no requieren influencia externa para ajustar los pesos.

Aprendizaje hebbiano

Permite medir la familiaridad o extraer las características de los datos de entrada.

Aprendizaje competitivo y comparativo

Aprendizaje por refuerzo

Comentarios

Publicar un comentario